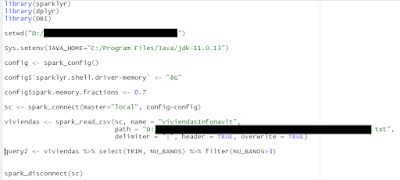

Librería de REDATAM para R

Introducción. En el segundo año de la pandemia (tomando como referencia que en marzo de 2020 se decidió a nivel mundial el confinamiento masivo), en mayo del 2021, tuvimos una reunión con el equipo de REDATAM , la DAERAS y algunos invitados, los compañeros de la CELADE encabezados por Lenin Aguinaga dejaron una agradable impresión, aunque en el Instituto seguimos ajenos a este software gratuito y muy destacado debido a la velocidad con la que hace las consultas. En los últimos años una gran cantidad de compañeros se han incorporado al Instituto con un perfil matemático, que los hace fuertes candidatos a integrar y migrar sus conocimientos al campo de la ciencia de datos. Junto con nuestros compañeros, y también debido al auge de la profesión más sexi del siglo 21 – el científico de datos - (según el artículo de Davenport y Patil del 2012), el lenguaje de programación R ha empezado a poblar de líneas de código los ordenadores de nuestro Instituto. Es por ello que traer la vel